Pourquoi Stadia va tout défoncer…

2. Une réflexion technologique long termiste incroyable

La manette

La première chose intéressante c’est la manette. Elle a été pensée pour évoluer. Un bouton Google assistant et un bouton capture par exemple. Les mises à jour firmware sont régulières et d’ailleurs se fait au premier allumage de la manette ! Pas courant …

Elle dispose du bluetooth qui est classique, d’une prise Jack, d’un micro mais également du wifi. Et ce dernier point est loin d’être anodin…

On passe de :

- Bouton pressé

- Envoi par bluetooth à l’ordi

- Traitement ordi

- Transmission input par internet à Stadia

à

- Bouton pressé

- Transmission input par internet à Stadia

Fallait y penser pour gagner 20 à 50 ms de latence !

Côté serveur on s’est fait plaiz

L’avantage du cloud c’est la puissance des datacenters avec des liens ultra low latency.

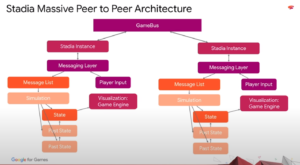

La première réflexion de Google a été de tout structurer autour d’un axe ultra basse latence permettant aux instances de jeux de dialoguer à la vitesse de la lumière : le GameBus.

La vraie grosse révolution qui fait le caractère unique de stadia, c’est de sortir du modèle monolithe du PC ou de la Console dans lequel tout pour faire tourner un jeu est rassemblé en une machine. Au contraire on explose tout dans une architecture distribuée : les binaries des jeux, les données des joueurs, les modules de rendu, les extensions de calcul IA ou physique…

Tout est SCALABLE (utiliser plusieurs instances pour un seul utilisateur).

Tout est INTERCHANGEABLE (utiliser un module de rendu plus puissant pour un jeu particulier par exemple).

En pratique ca apporte quoi ?

Un stockage est centralisé : Pas besoin d’installer les jeux x fois : les binaires sont au même endroit. Sur des SSD ultra rapide. Une game dans Stadia battent des record de temps d’ouverture… On peut également imaginer des jeux à 6 Terra octets sans qu’ça gêne par exemple.

Grace au partage possible des modules, Le calcul des informations physiques d’un monde persistant peut être centralisée sur une ou plusieurs instance(s) de calcul physique. Tous les joueurs utilisant ces ressources calculées en commun on peut imaginer des monde où tout est strictement pareil chez tout le monde jusqu’à la moindre feuille… On pourrait même se projeter sur un Battlefield à 500 contre 500 …

Les calculs d’IA peuvent être délégués a un service à côté permettant des dialogues toujours plus riches, des actions toujours plus réalistes avec du machine learning partagé entre les parties des joueurs…

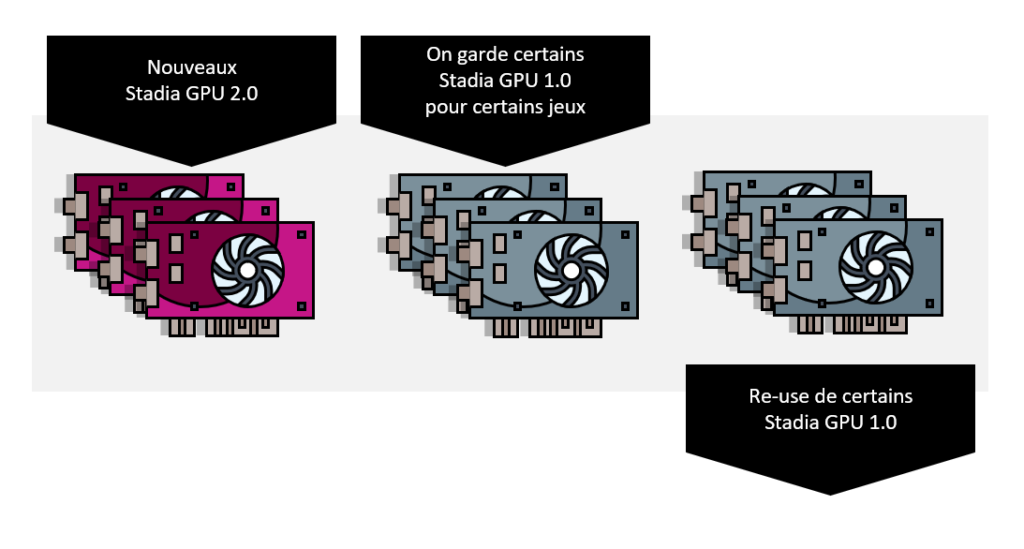

Mais surtout l’ENORME avantage de cette architecture, c’est de pouvoir faire évoluer en cycle court les instances : Tu veux sortir une évolution de ton composant graphique pour certains jeux ? Tu ajoute des racks de ton nouveau composant GPU. Selon le jeu, le joueur sans le savoir utilise le nouveau ou l’ancien. En plus comme Google va créer d’autres datacenters Stadia dans le monde il pourra récupérer les racks changés pour les amener dans un autre pays afin de supporter les jeux les moins gourmands de son catalogue.

Ces cycles peuvent même être courts (1 ans pour certains composants) car les composants évoluent constamment et leurs prix baissent vite.

Les modules peuvent être recyclés pour ouvrir des Datacenters Stadia dans des pays non desservis ou pour d’autre utilisations dans le cloud de Google (tensor flow…)

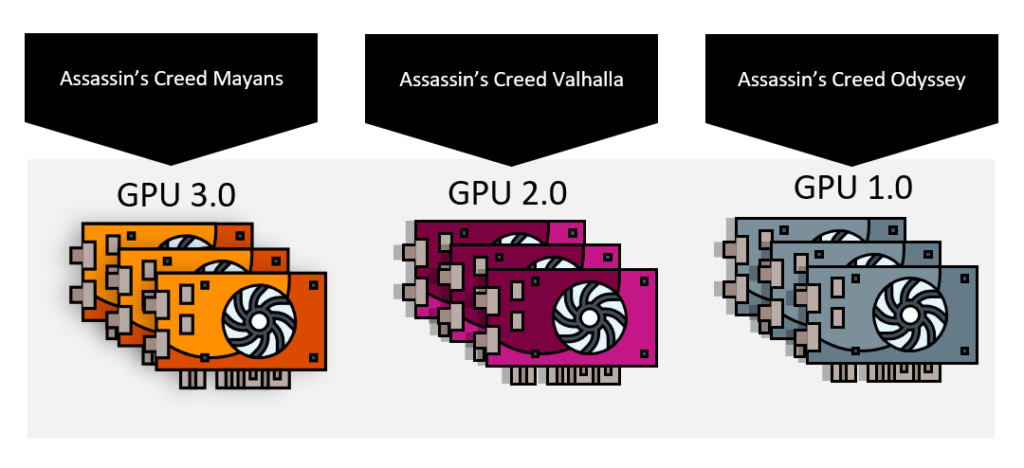

On pourra vite arriver à un truc du genre :

Une console de 5 ans de vie sera très très vite dépassée techniquement…

Encore une fois, Stadia c’est ORGANIQUE. Ca évoluera en permanence.

Rejoinds moi sur le discord de Stadia FR

Rejoinds moi sur le discord de Stadia FR